¿Superinteligencia Artificial en 2027?

Ejercicio predictivo de lo que ocurrirá con la IA en los próximos dos años, en todo caso la capacidad predictiva en esta materia es bastante baja.

Hace unos días llegué este sitio AI 2027 en el cual se hacen predicciones respecto del futuro inmediato de la IA. En todo caso, con esto de las predicciones, hay que ser muy cuidadoso, hemos visto como en el pasado reciente, predicciones en este ámbito no han andado ni por cerca, ya lo mencionaba en un post anterior: La IA y la bolita de cristal.

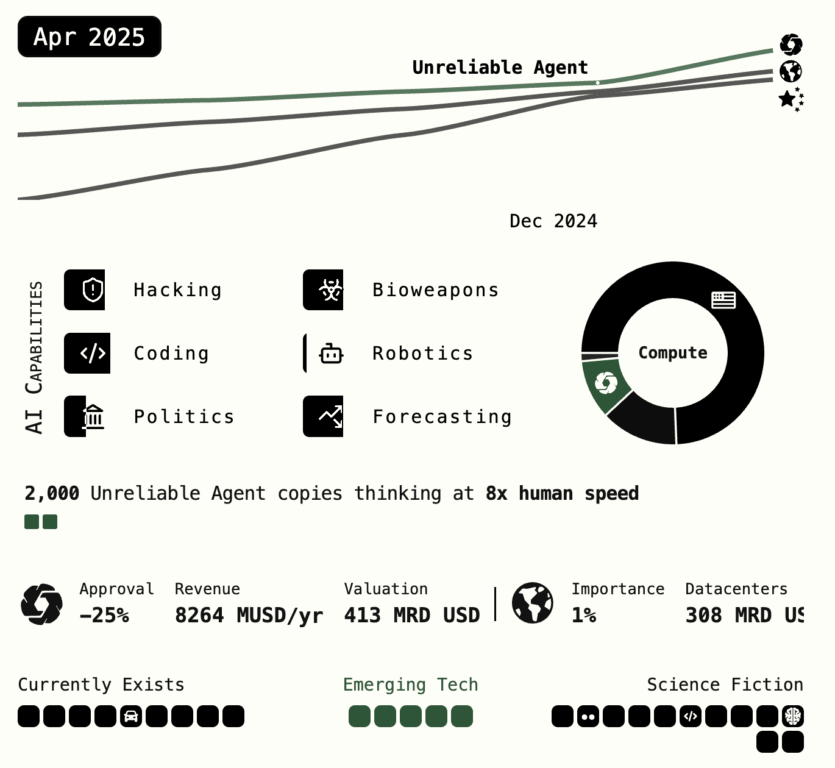

El sitio en cuestión, predice como se desarrollará la IA entre mediados de 2025 y 2027, en particular respecto del desarrollo de una Superinteligencia Artificial (ASI), la ASI está un paso más allá de la AGI (AGI – Artificial General Intelligence).

El análisis revisa diferentes dimensiones en dicho desarrollo: perspectiva técnica, ética, política pública, llegado incluso a aspectos geopolíticos (relaciones USA-China).

Predicción de alto impacto y alta incertidumbre

El escenario proyectado en AI-2027 no parte de la nada: se basa en tendencias, como el crecimiento exponencial en la capacidad computacional, el surgimiento de modelos fundacionales cada vez más grandes, capaces, y la intensa competencia por el liderazgo en materias de IA.

El argumento plantea que en poco tiempo podríamos ver sistemas que no solo igualen, sino superen ampliamente la inteligencia humana en múltiples dominios, esta predicción se sustenta en un conjunto de supuestos que hoy están lejos de contar con consensos. Algunos de ellos:

- Los modelos podrán automatizar eficazmente la investigación en IA.

- Que no habrá barreras regulatorias significativas.

- Que el progreso técnico continuará a ritmos exponenciales

Otros expertos

Frente a estas predicciones, múltiples voces de la comunidad científica han manifestado escepticismo. Gary Marcus, uno de los críticos más influyentes del hype en torno a la IA, ha sido especialmente enfático:

“No hay evidencia creíble de que estemos cerca de una inteligencia artificial general. Los modelos actuales no entienden, no razonan y no aprenden como lo hacen los humanos”.

Marcus no niega el potencial de la IA, pero advierte contra las predicciones alarmistas que no se basan en datos, sino en extrapolaciones agresivas.

Otros como Yann LeCun (Meta) y Melanie Mitchell (Santa Fe Institute) han hecho observaciones similares, recordando que la inteligencia general requiere más que procesamiento estadístico: necesita una arquitectura cognitiva robusta, sentido común y adaptabilidad a diferentes contextos y situaciones.

Y la Gobernanza

Independientemente de cuán probable sea un escenario como el de AI-2027, este tipo de ejercicios tiene el valor de que nos obliga a reflexionar sobre nuestra preparación institucional, regulatoria y ética. La cual me atrevería a decir que es baja, como lo expresaba en una columna.

- ¿Estamos dotando a nuestras democracias de marcos de gobernanza que puedan enfrentar futuros tecnológicos disruptivos?

- ¿Estamos invirtiendo lo suficiente en interpretabilidad, auditabilidad y gobernanza algorítmica?

Más allá del año en que la ASI llegue –si es que llega–, lo urgente es fortalecer nuestras capacidades de gobernanza anticipatoria.

La historia reciente de internet y redes sociales ya nos ha mostrado los costos de regular demasiado tarde.

Conclusión

AI-2027 plantea un escenario útil, no tanto por su exactitud predictiva, sino por su capacidad de activar el debate.

Pero como advierten Marcus y otros, debemos separar la especulación informada del alarmismo. La tarea de fondo no es adivinar el año en que surgirá la superinteligencia, sino construir desde ya un ecosistema de desarrollo tecnológico responsable, alineado con el interés público.