La IA devora energía: el costo invisible de la revolución digital

Mientras celebramos la inteligencia artificial como símbolo de progreso, ignoramos su apetito energético voraz. ¿Cuánta electricidad consume ChatGPT? ¿Quién paga esa cuenta? Y lo más importante: ¿hasta cuándo podremos sostener este modelo?

La IA y el consumo energético es un tema que está dando vueltas hace rato, Kate Crawford en su libro el Atlas de la IA, ya lo hacía ver, creo que a estas alturas es el elefante en la habitación

La inteligencia artificial no solo está transformando la manera en que trabajamos, nos comunicamos y tomamos decisiones. También está reconfigurando —en silencio y a gran escala— el mapa energético del mundo. En un reciente artículo, el MIT Technology Review We did the math on AI’s energy footprint. Here’s the story you haven’t heard se dio el trabajo de: cuantificar el impacto energético real de la IA, algo que muy pocos han realizado en forma rigurosa, el cual se complementa con el estudio 2024 United States Data Center Energy Usage Report, desarrollado por el Energy Analysis & Environmental Impacts Division del Berkeley Lab.

Los hallazgos y conclusiones del análisis son preocupantes y desafían a varios de los supuestos optimistas que plantean que el importante incremento de la eficiencia tecnológica van a reducir sustancialmente ese impacto.

📊 ¿Cuánta energía consume realmente la IA?

Aunque una sola consulta a alguno de los modelos de IA Generativa o la generación de una imagen pueda parecer trivial —energéticamente hablando— ,recordemos millones de personas generando imágenes a partir de fotos con estilo Ghibli, incluyéndome, según Brad Lightcap, COO de OpenAI, fueron 700 millones de imágenes generadas en una semana, el impacto agregado de miles de millones de consultas diarias es enorme.

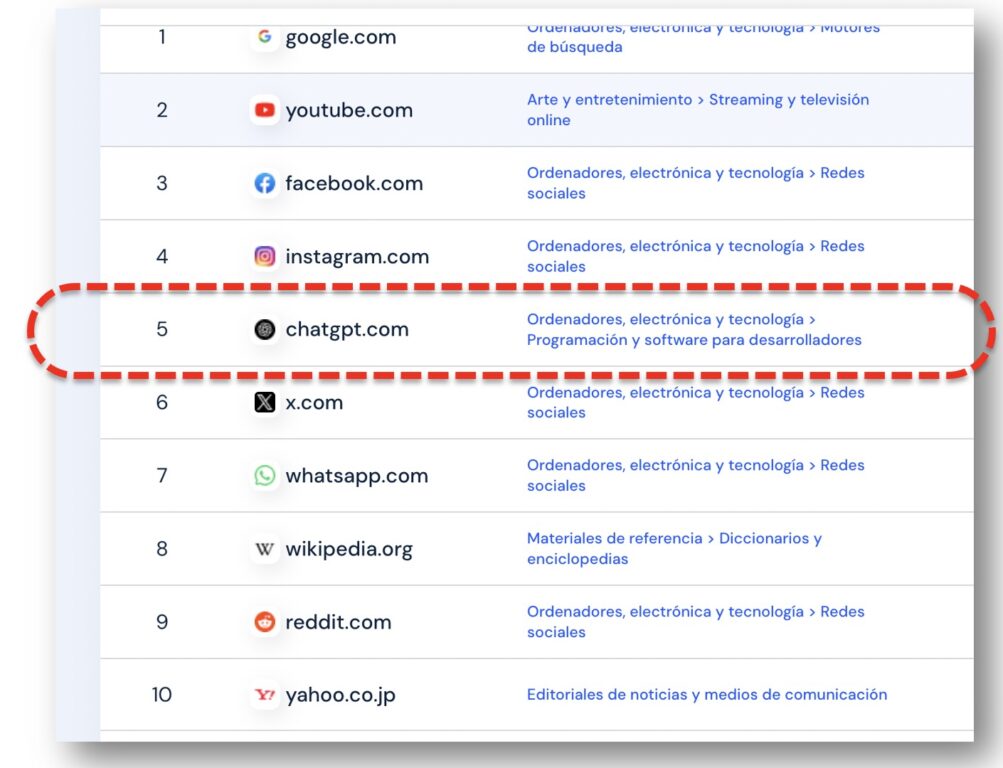

- Según SimilarWeb, ChatGPT, hoy el quinto sitio más visitado del mundo, procesa más de mil millones de mensajes diarios.

- Solo con ese volumen, se estima que consume más de 109 gigavatios-hora por año, suficiente para alimentar 10.400 hogares.

- Y eso sin contar imágenes, videos ni otros servicios complementarios.

- Según PG&E (la empresa eléctrica más grande de California), ha identificado un aumento de más del 40% este año en las solicitudes de suministro de energía de los desarrolladores de centros de datos en todo el norte del estado, los cuales se concnetran en el área de la IA.

- En Santa Clara, el corazón de Silicon Valley, las tarifas eléctricas están subiendo porque la empresa municipal gasta mucho en líneas de transmisión y otras infraestructuras para dar cabida a la voraz demanda de energía de más de 50 centros de datos, que ahora consumen el 60% de la electricidad de la ciudad.

⚙️ Entrenamiento vs. Uso diario: el verdadero gasto está en las consultas

El entrenamiento de modelos como GPT-4 consumió más de 50 GWh de energía. Sin embargo, el verdadero “agujero negro” energético está en el uso cotidiano, debido a la masividad de uso: se estima que el 80–90% del gasto energético actual se concentra en las consultas, es decir, cuando las personas interactúan con los modelos.

Esto cambió mi percepción de que era más caro el entrenamiento, que lo es pero a nivel unitario, y no ahora que millones de personas usan IA en forma cotidiana y esa diferencia de consumo entre entrenamiento y uso irá en aumento.

Algunos de los consumos que plantea el artículo son:

- Respuesta de texto simple puede consumir 114 joules (si lo quieren llevar a watt-hora usen esta calculadora).

- Generación de una imagen de buena calidad: 4.400 joules.

- Generación de un video de 5 segundos: más de 3,4 millones de joules.

🔌 Un sistema eléctrico bajo presión… y sin transparencia

El avance de la IA no solo aumenta la demanda energética. También genera nuevos riesgos estructurales:

- Falta de transparencia: las grandes tecnológicas (OpenAI, Meta, Google, Microsoft) no revelan cifras sobre consumo o fuentes de energía, la falta de transparencia es muy grande.

- Energía sucia: muchos centros de datos donde operan estos modelos funcionan en redes intensivas en carbón o gas natural. La huella de carbono de estos centros es 48% más alta que el promedio nacional en EE.UU..

- Externalización de costos: los acuerdos que están realizando las empresas eléctricas (un buen ejemplo es Meta) y gigantes tecnológicos podrían derivar en alzas tarifarias para consumidores residenciales.

🧭 Un futuro que se perfila más demandante

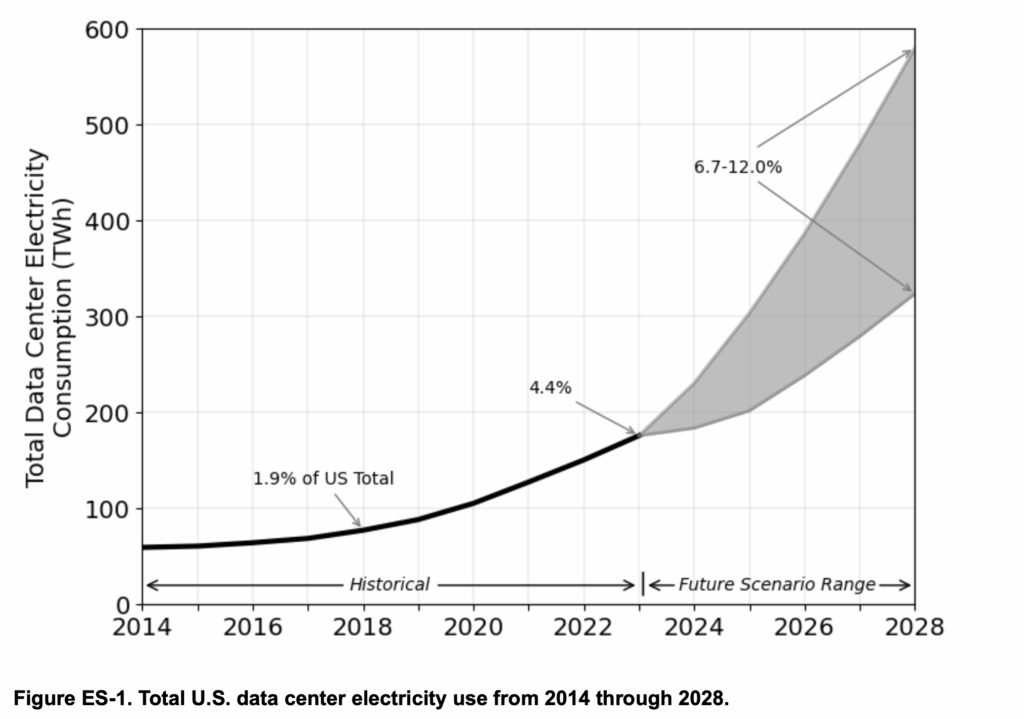

Si las tendencias actuales se mantienen, la situación se agravará. Para 2028, se estima que:

- El consumo de los Data center podría llegar al 12% del consumo general de energía en los Estados Unidos al 2028, con una tasa de crecimiento anual que va entre el 13% y 27%.

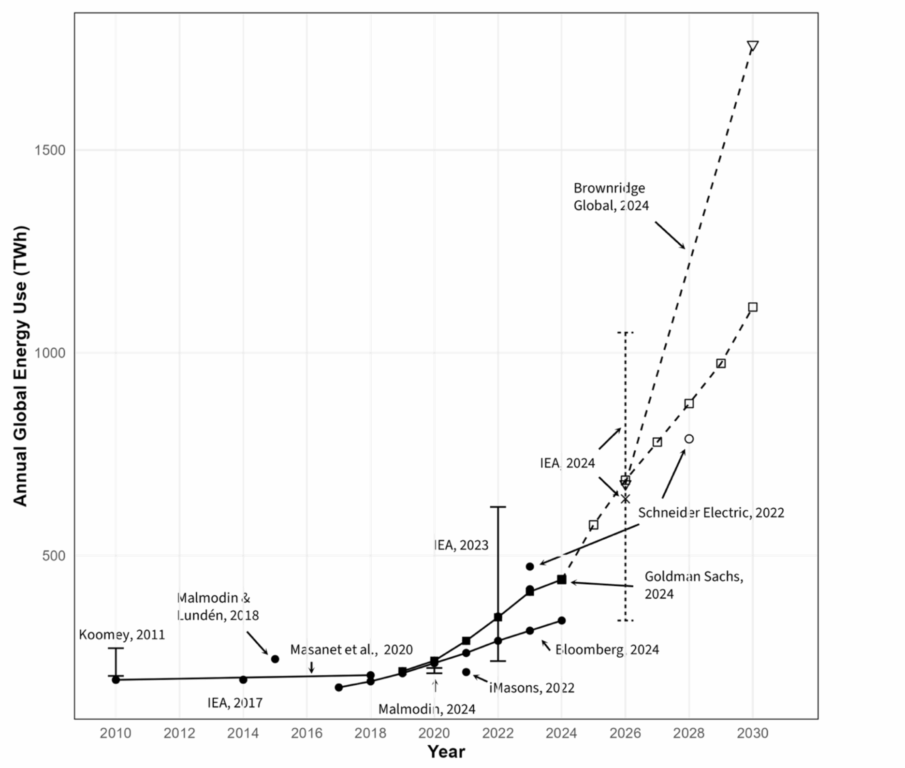

- El mismo estudio muestra que el consumo mundial se multiplicaría por 3 en menos de 10 años según algunas estimaciones.

- Los centros de datos representaron alrededor del 1,5 por ciento del consumo mundial de electricidad en 2024, una cantidad que se espera que se duplique en 2030 debido al uso de la IA.

- Más del 50% de la energía de los centros de datos se destinará exclusivamente a IA.

- El consumo de IA podría llegar a los 326 teravatios-hora al año, lo que equivale al uso eléctrico del 22% de los hogares en los Estado Unidos.

Y esto, considerando solo la infraestructura conocida. A esto se suma el desarrollo de nuevas capacidades: agentes autónomos, razonamiento complejo, modelos personalizados… todo más intensivo en energía.

🌐 ¿Quién paga esta revolución?

El informe plantea una pregunta ética y política fundamental:

¿Quién está financiando el auge energético de la IA?

Si las compañías de IA obtienen subsidios eléctricos o incentivos para construir mega data centers sin evaluar su impacto ambiental y social, los costos serán asumidos —literalmente— por el resto de la sociedad. Y esto incluye a países como Chile, que también avanza en su estrategia de digitalización, muchas veces sin tener claridad sobre los costos ocultos del modelo tecnológico que importamos.

🧠 Conclusión: necesitamos una gobernanza energética para la IA

La IA llegó para quedarse, pero su integración al tejido económico y digital requiere más que entusiasmo. Requiere información pública, métricas claras y decisiones políticas conscientes sobre qué tipo de futuro energético estamos construyendo.

Porque si no lo hacemos ahora, es probable que el costo —ambiental, económico y social— sea mucho mayor de lo que imaginamos.

Información Complementaria

- Informe: 2024 United States Data Center Energy Usage Report, desarrollado por el Energy Analysis & Environmental Impacts Division del Berkeley Lab.

- Artículo del MIT Technology Review We did the math on AI’s energy footprint. Here’s the story you haven’t heard

- Data Centers Will Use Twice as Much Energy by 2030—Driven by AI

Qué buen artículo Alejandro!!! en el centro de las preocupaciones de las que hacerse cargo hoy para el futuro. Gracias!

Muchas gracias Isabel, efectivamente en este tema viene cosas preocupantes si no tomamos acciones desde ya